A HUN-REN-ELTE Összehasonlító Etológiai Kutatócsoport és a Debreceni Egyetem szakemberei azt vizsgálták, hogy az állatok esetében is megfigyelhető, távolodást vagy közeledést kiváltó nem verbális hangjelzések szabályszerűségei átültethetők-e mesterségesen létrehozott gépi hangokba.

Vajon milyen hangokat használjon egy robot, ha azt „szeretné”, hogy az emberek közeledjenek hozzá, vagy épp ellenkezőleg, távol maradjanak tőle? Ahogy egyre több segítőrobottal találkozunk éttermekben, bevásárlóközpontokban és hotelekben, egyre fontosabbá válik, hogy ezek a gépek intuitív módon kommunikáljanak velünk. Elsőre a beszéd és a mesterséges intelligencia tűnhet megoldásnak, ám

az ember gyakran támaszkodik nem verbális jelzésekre is,

mint például a nevetés vagy a sóhajtás. Ezek segítségével még nyelvtudás nélkül is képesek vagyunk értékelni valaki érzelmi állapotát, és eldönteni, hogy megközelítsük-e, vagy inkább távolodjunk el tőle.

Amikor egy kutya hosszan morog ránk, tudjuk, hogy jobb, ha nem közelítünk hozzá. Ha viszont egy síró emberi hang szűrődik át a szomszéd szobából, késztetést érzünk, hogy odamenjünk segíteni. „Ez nem csak ránk, emberekre igaz, hanem az állatvilágban is megfigyelhető: az érzelemkifejező és távolságot szabályozó hangok akusztikai jellemzői sok szárazföldi emlős fajnál hasonlóak, mivel a hangképző szervek felépítése hasonló” – magyarázza Faragó Tamás, az ELTE Etológiai Tanszék kutatója.

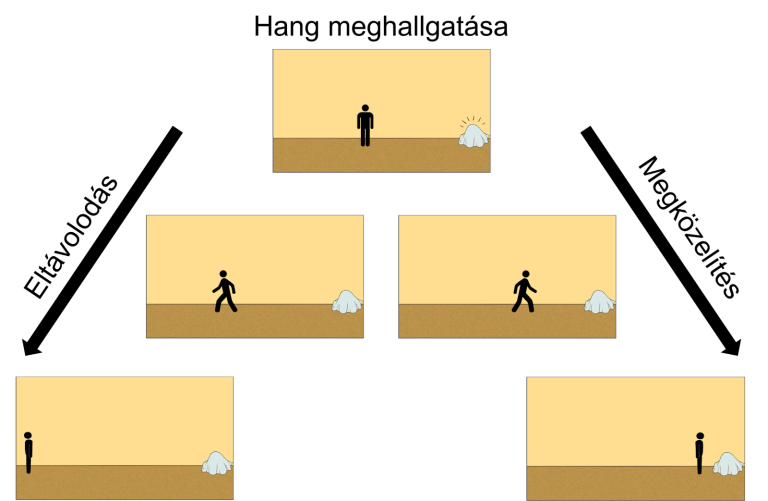

A HUN-REN-ELTE Összehasonlító Etológiai Kutatócsoport és a Debreceni Egyetem szakemberei arra keresték a választ, hogy az állatok hangadására vonatkozó szabályszerűségek – amelyek befolyásolják, hogy milyen hang hatására közelít vagy távolodik egy másik állat – átültethetők-e mesterségesen létrehozott gépi hangokba. A Scientific Reports folyóiratban publikált vizsgálatban önkéntesek közelítési és elkerülési reakcióit mérték egy interaktív online kérdőív segítségével, amelyben a résztvevők egy képernyőn megjelenített figurát irányítottak a hallott mesterséges hangok alapján: közeledtek vagy távolodtak a hangforrástól.

A figurát a résztvevők egérrel vagy billentyűzettel tudták a megjelenített hangforráshoz közelebb, vagy attól távolabb húzni. A kutatók a hangforrást egy letakart objektumként ábrázolták, hogy az önmagában ne befolyásolja a válaszokat.

„Az emberek és állatok érzelemkifejező hangjelei alapján hoztuk létre a lejátszott ingereket, az egyszerű sípolásoktól kezdve a biológiai szempontból komplexebb hangokig”- mondta Gácsi Márta, az ELTE Etológia Tanszék vezető kutatója. Az eredmények azt mutatják, hogy

a mesterségesen generált rövid hangok általában közeledést váltottak ki,

míg a hangosabb hangok elkerülést idéztek elő, függetlenül azok bonyolultságától.

A hangmagasság bonyolultabb hatást fejtett ki. A magas hangok esetében a reakció a hangerőtől függött: a hangos magas hangok elkerülést váltottak ki, míg a halk magas hangok közeledést. A mélyebb hangoknál a biológiai összetettség számított: a formánsokat (a hangút bizonyos frekvenciákat szűrő/felerősítő hatásából adódó hangtani tulajdonság, ami a hang öblösségéhez járul hozzá) tartalmazó mély hangok elkerülést váltottak ki, míg a formánsok nélküli mély hangok inkább közeledést eredményeztek.

A magyar kutatók eredményei szerint a szociális robotok az emberi környezetben olyan akusztikai jelkészlettel is felruházhatók, amely beszéd nélkül is hatékonyan segíti a kommunikációt. Így azokban a helyzetekben, amikor nincs szükség nyelvi interakcióra, a segítőrobotok működése egyszerűbbé, valamint kultúra- és nyelvfüggetlenné válhat – teszi hozzá Korcsok Beáta, a tanulmány egyik első szerzője.

Forrás: Eötvös Loránd Tudományegyetem, továbbította a Helló Sajtó! Üzleti Sajtószolgálat.